笔记三十:集群分布式模型与选主与脑裂问题

分布式特性

- ES的分布式架构带来的好处

- 储存的水平扩容,支持PB级数据

- 提高系统的可用性,部分节点停止服务,整个集群的服务不受影响

- ES的分布式架构

- 不同的集群通过不同的名字来区分,默认名字“es”

- 通过配置文件的修改,或者在命令行中-E cluster.name=’**** ‘设定

节点

- 节点是一个ES的实例

- 其本质就是一个JAVA进程

- 一台机器可以运行多个ES进程,但是生产环境一般建议一台机器就运行一个ES实例

- 每一个节点都有名字,通过配置文件配置,或者启动时候-E node.nam=geektime指定

- 每一个节点在启动之后,都会分配一个UID,保存在data目录下

Coordinating Node

- 处理请求的节点,叫Coordinating Node

- 路由请求到正确的节点,例如创建索引的请求,需要路由到Master 节点

- 所有节点默认都是Coordinating Node

- 通过将其他类型设置成False ,使其成为Dedicated Coordinating Node

Demo 启动节点,Cerebro介绍

- 启动一个节点

- bin/elasticsearch -E node.name=node1 -E cluster.name=geektime -E path.data=node1_data -E http.port=9200

- https://github.com/lmenezes/cerebro/releas...

Demo 创建一个新的索引

- 发送创建索引的请求

- Settings 3 Primary 和1个Replica

- 请求可以发送到任何的节点,处理你请求的节点,叫做Coordinating Node

- 创建/删除 索引的请求,只能被Master节点处理

Data Node

- 可以保存数据的节点,叫做Data Node

- 节点启动后,默认就是数据节点。可以设置

node.data:false禁止

- 节点启动后,默认就是数据节点。可以设置

- Data Node 的职责

- 保存分片数据。在数据扩展上起到了至关重要的作用(由Master Node决定把分片分发到数据节点上)

- 通过增加数据节点

- 可以解决数据水平扩展和解决数据单点的问题

Master Node

- Master Node 的职责

- 处理创建,删除索引等请求/ 决定分片被分配到哪个节点/负责索引的创建与删除

- 维护并且更新Cluster State

- Master Node 的最佳实践

- Master 节点非常重要,在部署上需要考虑解决单点的问题

- 为一个集群设置多个Master节点 / 每个节点值承担Master 的单一角色

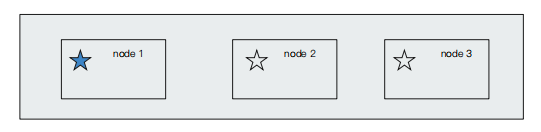

Master Eligible Nodes & 选主流程

- 一个集群,支持配置多个Master Eligble 节点。这些节点可以在必要时(如Master 节点出现故障,网络故障时)参与选主流程,成为Master节点

- 每个节点启动后,默认就是一个Master eligible节点

- 可以设置

node.data:false

- 可以设置

- 当集群内的第一Master eligible节点时候,它会将自己选举成Master节点

集群状态

- 集群状态信息(Cluster State),维护了一个集群中,必要的信息

- 所有的节点信息

- 所有的索引和其相关的Mapping 与 Setting 信息

- 分片的路由信息

- 在每个节点都保存了集群的状态信息

- 但是,只有Master节点才能修改集群的状态信息,并负责同步给其他节点

- 因为,任意节点都能修改信息会导致Cluster State 信息不一致

Demo 增加一个新的节

- bin/elasticsearch -E node.name=node2 -E cluster.name=geektime -E

path.data=node2_data -E http.port=9201 - Nodes API 看到新增节点

- 发现Replica被分配

Master Eligbile Nodes & 选主的过程

- 互相ping 对方。Node Id 低的会被成为被选举的节点

- 其他节点会加入集群,但是不承担Master 节点的角色。一旦发现被选中的主节点丢失,救护选举除新的Master 节点

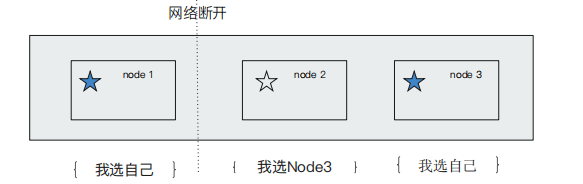

脑裂问题

- Split-Brain ,分布式系统的经典网络问题,当出现网络问题,一个节点和其他节点无法连接

- Node 2 和 Node 3会被重新选举Master

- Node 1自己还是作为Master,组成一个集群,同时更新Cluster State

- 导致2个master,维护不同的cluster state。当网络恢复是,无法选择正确恢复

- (下图疑问) 这个不是应该根据Node Id 选2吗?

如何避免脑裂问题

- 限定一个选举条件,这是quorum(仲裁),只有在Master eligble节点数大于quorum时,才能进行选举

- Quorum = (master 节点总数/2) +1

- 当3个master eligible时,设置

discovery.zen.minimum_master_nodes为2 ,即可避免脑裂

- 从7.0开始,无需这个配置

- 一个节点默认下是一个 Master eligible ,data and ingest node:

| 节点类型 | 配置参数 | 默认值 |

|---|---|---|

| maste eligible | node.master | true |

| datan | node.data | true |

| ingest | node.ingest | ture |

| coordinating only | ⽆ | 设置上⾯三个参数全部为false |

| machine | learning node.ml | true (需要enable x-pack) |

本节回顾

- ES 天生的分布式架构。为了实现数据可用性

- 部署多台Data Nodes,可以实现数据存储的水平扩展

- 提高服务可用性

- Master 节点非常重要。设置多台Master Eligible Nodes,同时设置合理的quorum数,避免脑裂问题

- 设置多台Coordinating Node ,提升查询的可用性和性能

本作品采用《CC 协议》,转载必须注明作者和本文链接

关于 LearnKu

关于 LearnKu