TF2.keras 实现基于深度可分离卷积网络的图像分类模型

在深度可分离卷积网络里,通常在输入层使用普通的卷积,在输入层之外的地方使用深度可分离卷积。由于 Keras 已经实现了深度可分离卷积,所以直接调用 API:keras.layers.SeparableConv2D 即可。

数据集以及一些其他步骤可以在 TF2.keras 实现基于卷积神经网络的图像分类模型 查看。

模型代码:

model = keras.models.Sequential()

# 卷积层

model.add(keras.layers.Conv2D(filters=32, kernel_size=3,

padding='same',

activation='selu',

input_shape=(28, 28, 1)))

# 深度可分离卷积

model.add(keras.layers.SeparableConv2D(filters=32, kernel_size=3,

padding='same',

activation='selu'))

# 池化层

model.add(keras.layers.MaxPool2D(pool_size=2))

# 深度可分离卷积

model.add(keras.layers.SeparableConv2D(filters=64, kernel_size=3,

padding='same',

activation='selu'))

# 深度可分离卷积

model.add(keras.layers.SeparableConv2D(filters=64, kernel_size=3,

padding='same',

activation='selu'))

# 池化层

model.add(keras.layers.MaxPool2D(pool_size=2))

# 深度可分离卷积

model.add(keras.layers.SeparableConv2D(filters=128, kernel_size=3,

padding='same',

activation='selu'))

# 深度可分离卷积

model.add(keras.layers.SeparableConv2D(filters=128, kernel_size=3,

padding='same',

activation='selu'))

# 池化层

model.add(keras.layers.MaxPool2D(pool_size=2))

# 展平

model.add(keras.layers.Flatten())

# 全连接层

model.add(keras.layers.Dense(128, activation='selu'))

model.add(keras.layers.Dense(10, activation="softmax"))

model.compile(loss="sparse_categorical_crossentropy",

optimizer = "sgd",

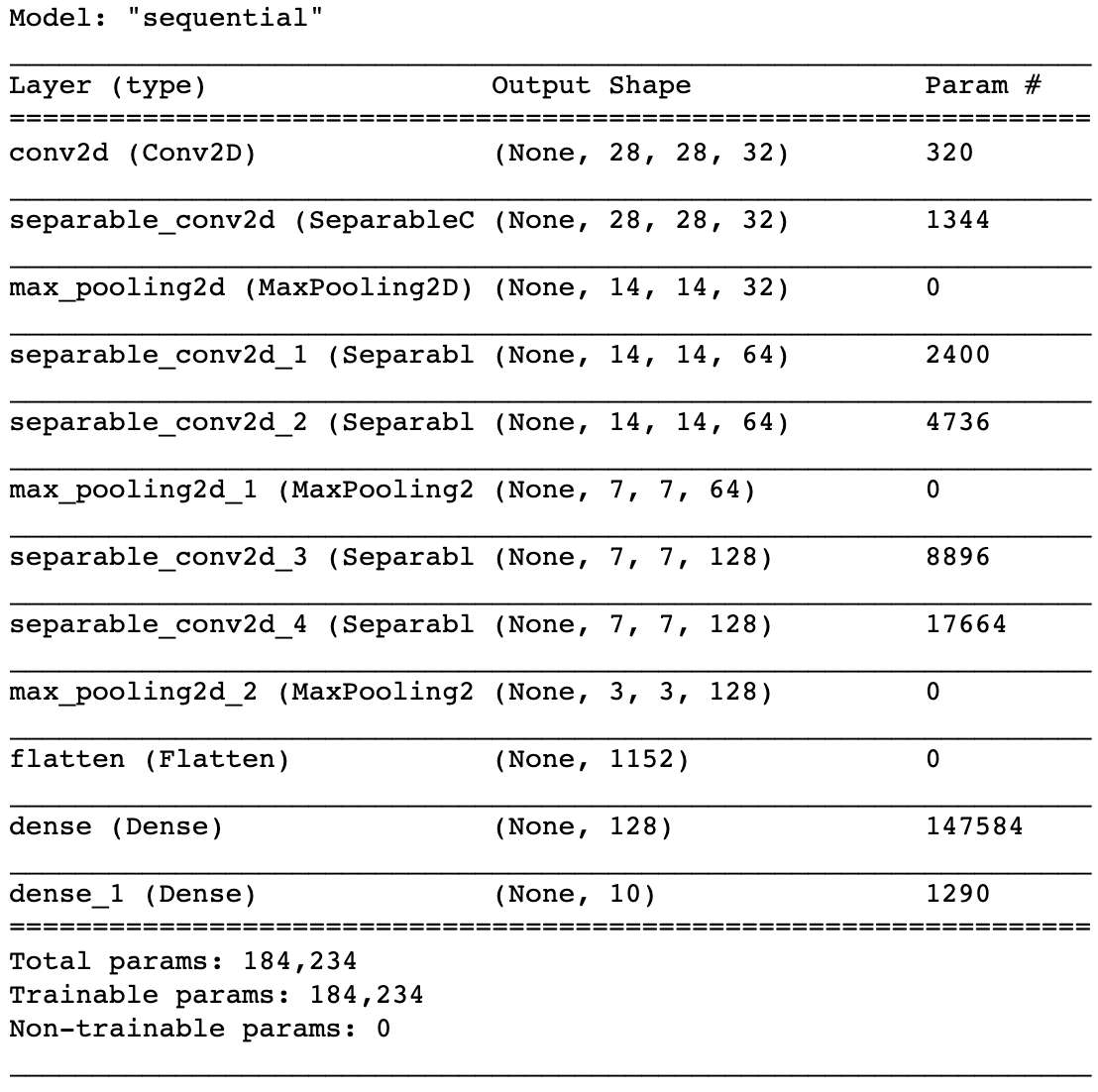

metrics = ["accuracy"])model.summary():

比起普通卷积网络,可以发现「深度可分离卷积网络」在参数量上的降低非常巨大。

训练网络模型:

logdir = './separable-selu-callbacks'

if not os.path.exists(logdir):

os.mkdir(logdir)

output_model_file = os.path.join(logdir,

"fashion_mnist_model.h5")

callbacks = [

keras.callbacks.TensorBoard(logdir),

keras.callbacks.ModelCheckpoint(output_model_file,

save_best_only = True),

keras.callbacks.EarlyStopping(patience=5, min_delta=1e-3)

]

history = model.fit(x_train_scaled, y_train, epochs=10,

validation_data=(x_valid_scaled, y_valid),

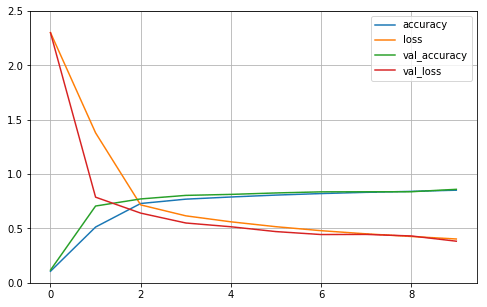

callbacks = callbacks)深度可分离卷积网络以精度损失为代价换取计算量的减少,参数量的减少。使得深度可分离卷积网络可以在手机上运行。

学习曲线:

def plot_learning_curves(history):

pd.DataFrame(history.history).plot(figsize=(8, 5))

plt.grid(True)

plt.gca().set_ylim(0, 2.5)

plot_learning_curves(history)

测试集验证:

model.evaluate(x_test_scaled, y_test)输出:

10000/10000 [==============================] - 3s 307us/sample - loss: 0.4113 - accuracy: 0.8506

[0.4112651606082916, 0.8506]

本作品采用《CC 协议》,转载必须注明作者和本文链接

关于 LearnKu

关于 LearnKu