[转载] 跨集群搜索 Cross-cluster search (CCS)

序言

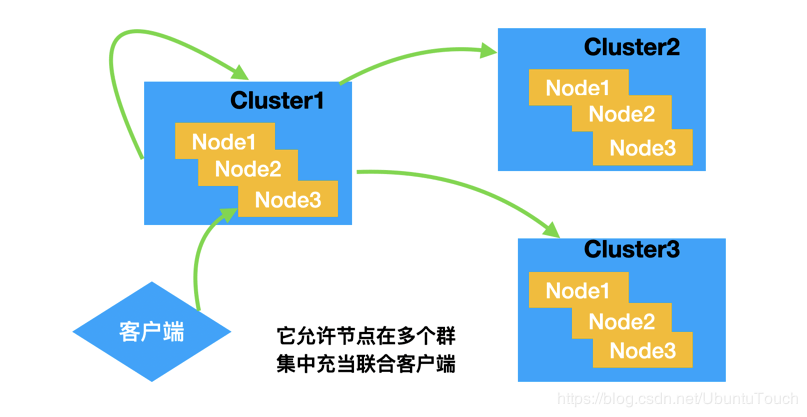

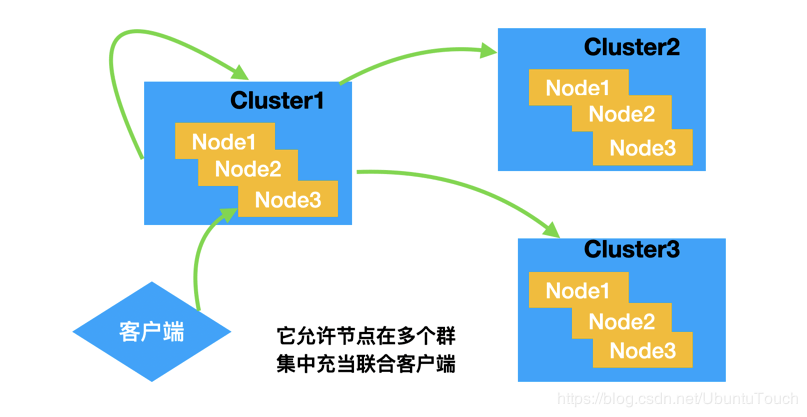

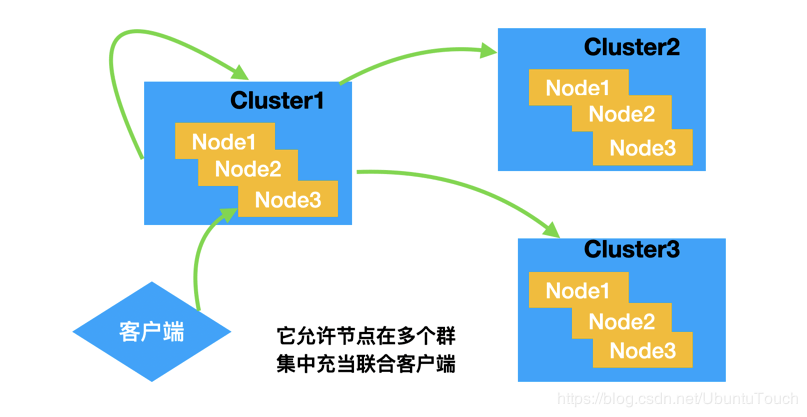

Elasticsearch 在 5.3 版本中引入了 Cross Cluster Search(CCS 跨集群搜索)功能,跨集群搜索功能允许任何节点在多个集群之间充当 Federated Client(联合客户端)与 Tribe Node(部落节点)功能相比,进行跨集群搜索的节点将不会加入远程集群,而是以轻量的方式连接到远程集群,以便执行联合搜索请求。

如上面所述,当我们的 client 向集群 cluster_1 发送请求时,它可以搜索自己本身的集群,同时也可以向另外的两个集群 cluster_2 及 cluster_3 发送请求。最后的结果由 cluster_1 返回给客户端。

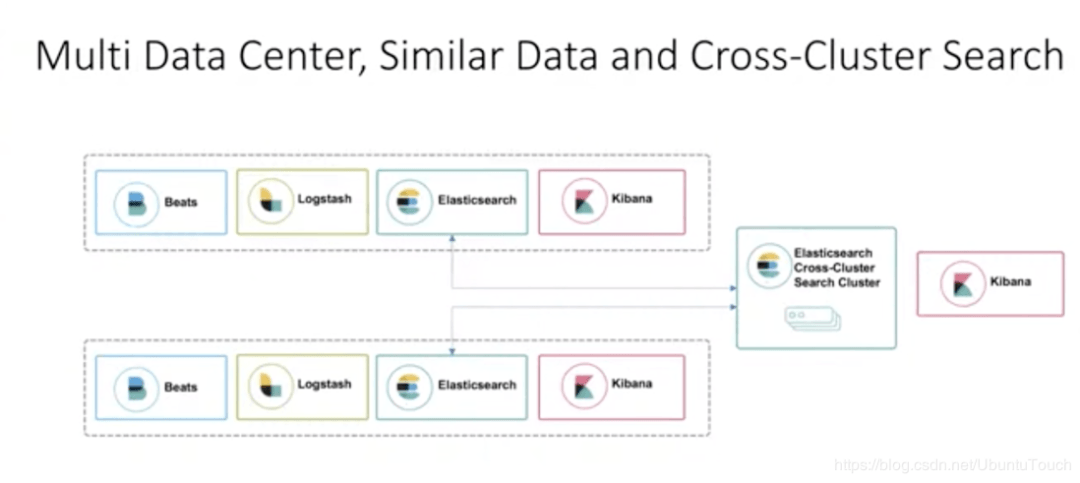

跨集群搜索案例

要执行跨集群搜索,必须至少配置一个远程集群。在群集设置中配置了远程群集

使用 cluster.remote 属性

种子(seeds)是远程集群中的节点列表,用于在注册远程集群时检索集群状态

以下 cluster update settings API 请求添加了三个远程集群:cluster_one,cluster_two 和 cluster_three。

PUT _cluster/settings安装集群

在今天的实践中,我们来设置两个集群:

在上面的描述中,我们配置了两个集群:cluster 1 及 cluster 2。它们位于同一个网路内,可以互相访问。如果你还没有安装好你的 Elasticsearch 集群的话,请参阅我之前的文章 “Elastic:菜鸟上手指南”安装好自己的 Elasticsearch 及 Kibana。

在安装时,我们必须注意的是:

把我们的 Elasticsearch 及 Kibana 分别解压,并安装于不同的两个目录中。这样它们的安装互相不干扰,从而能形成两个不同的集群,虽然它们集群的名字可以是一样的。为了方便,我们把两个集群的名字分别取为 cluster_1 及 cluster_2。

我们可以分别对 Elasticsearch 的配置文件 config/elasticsearch.yml 做如上的配置。同时我们也需要对 Kibana 之中的 config/kibana.yml 做配置,这样使得 cluster_1 对应的 Kibana 的口地址为 5601,而对于 cluster_2 的 Kibana 的口地址为 5602。

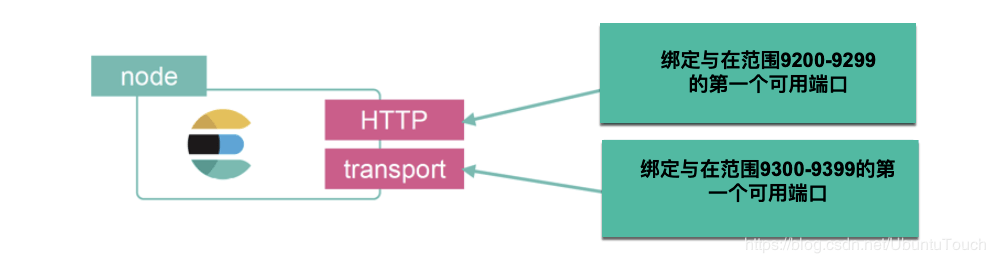

在上面可能有很多人感到疑问:为啥我们还需要配置端口地址 9300 及 9301?事实上,Elasticsearch 中有两种重要的网络通信机制需要了解:

HTTP:用于 HTTP 通信绑定的地址和端口,这是Elasticsearch REST API 公开的方式;

Transport:用于集群内节点之间的内部通信。

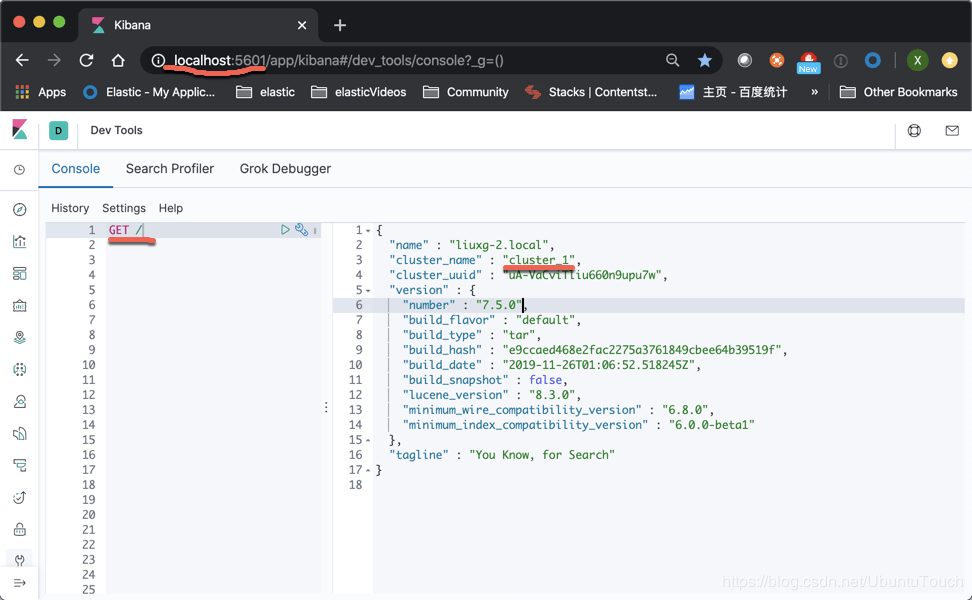

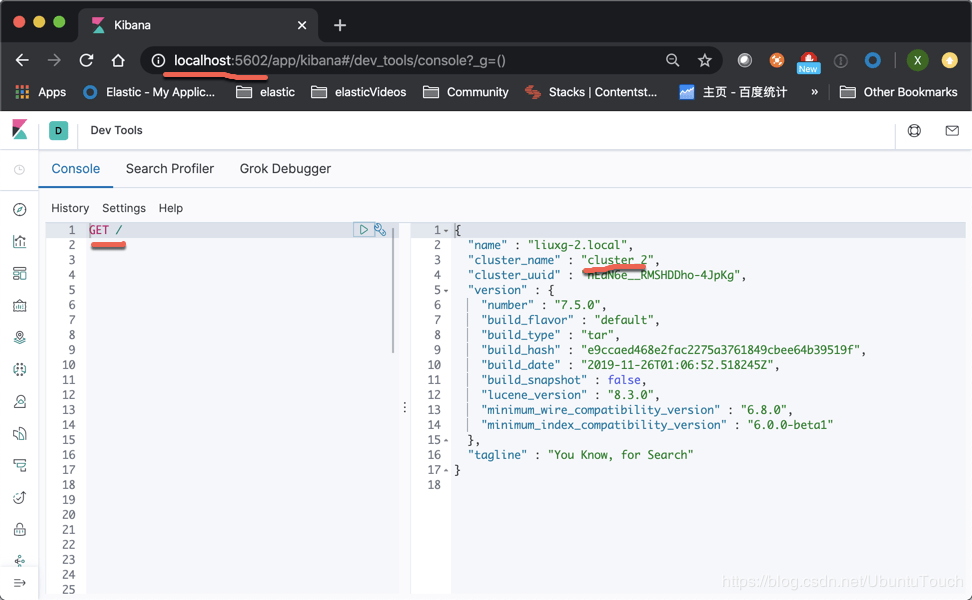

等我们安装好我们的两个集群我们可以通过如下的方法来查看 :cluster_1

cluster_2

搜索

我们接下来进行配置,我们在 kibana_2,也即是端口地址为 5602 的 Kibana,我们打入如下的命令:

PUT _cluster/settings在上面,我们在 cluster_2 里配置可以连接到 cluster_1 的这样设置,因为 cluster_1 的 transport 口地址是 9300。

我们可以看到如下的返回信息:

我们接下来使用如下的命令来检查我们的连接状态:

GET _remote/info我们可以看到如下的响应信息:

{它表明我们的连接是成功的。这个时候我们在 Kibana_1 中创建如下的 twitter 索引:

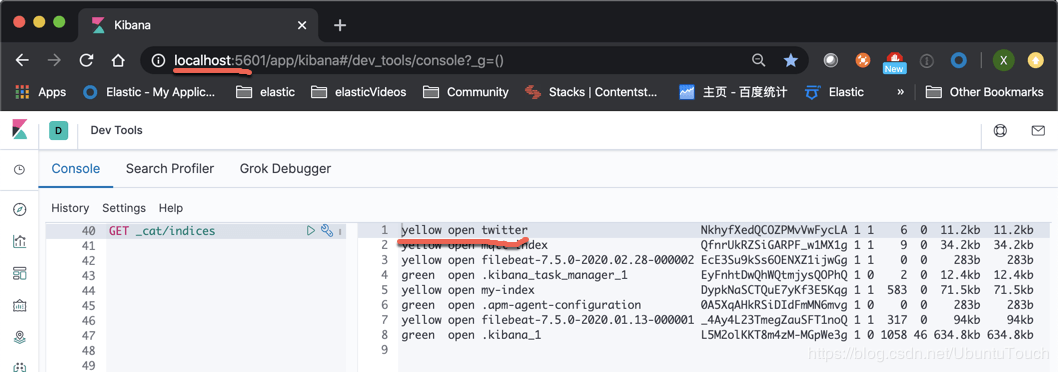

POST _bulk我们可以在 Kibana_1 中通过如下的命令来检查 twitter 索引是否已经被成功创建:

在上面,我们可以看到我们已经成功地在 cluster_1 上创建了 twitter 索引,那么我们怎么在 cluster_2 上对这个进行搜索呢?我们在 Kibana_2 里,打入如下的命令:

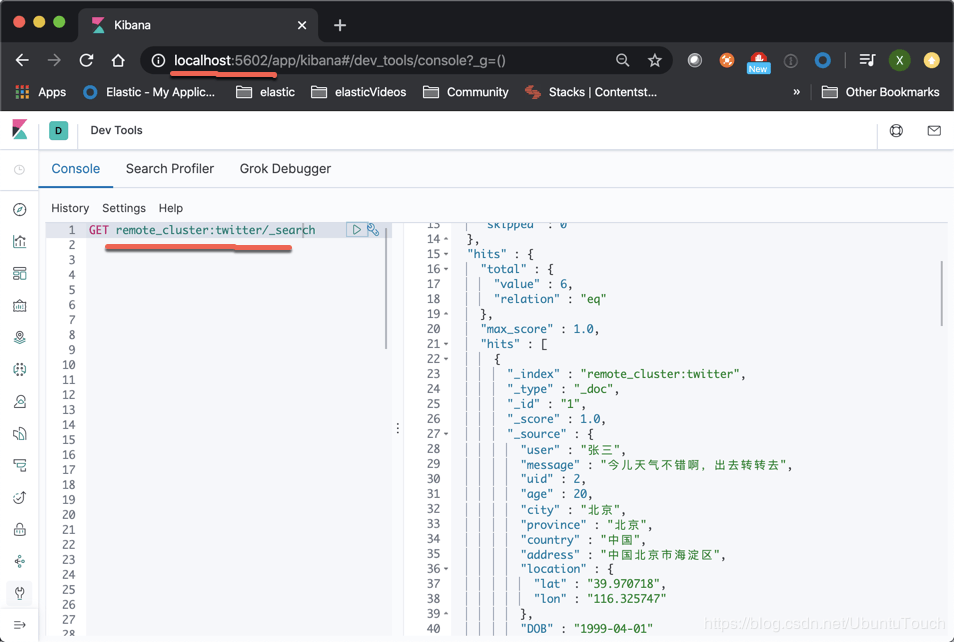

GET remote_cluster:twitter/_search我们将看到如下的输出:

从上面我们可以看出来,我们可以对位于 cluster_1 的 twitter 索引进行搜索。

03

对Remote索引进行分析

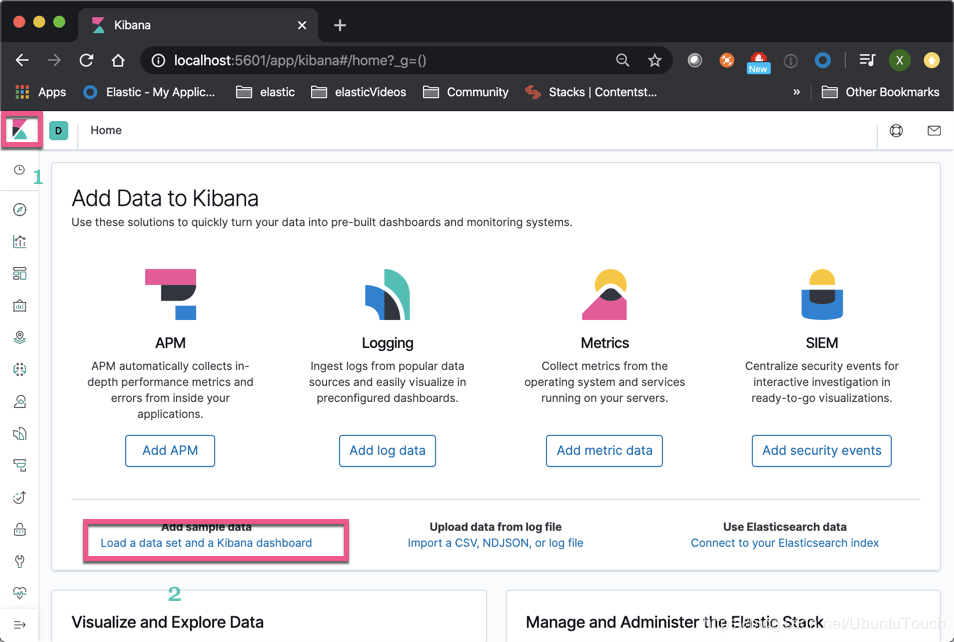

在 Kibana_1 中,我们通过如下的方法来加载我们的测试数据:

然后点击“Add data”:

这样在 cluster_1中,我们已经成功地加载了 Sample flight data 索引。

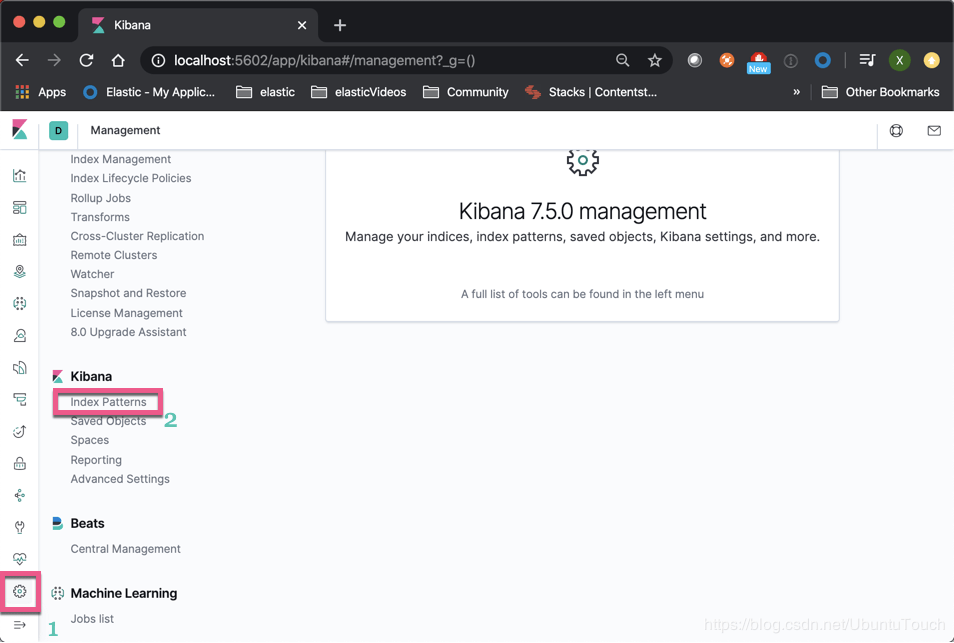

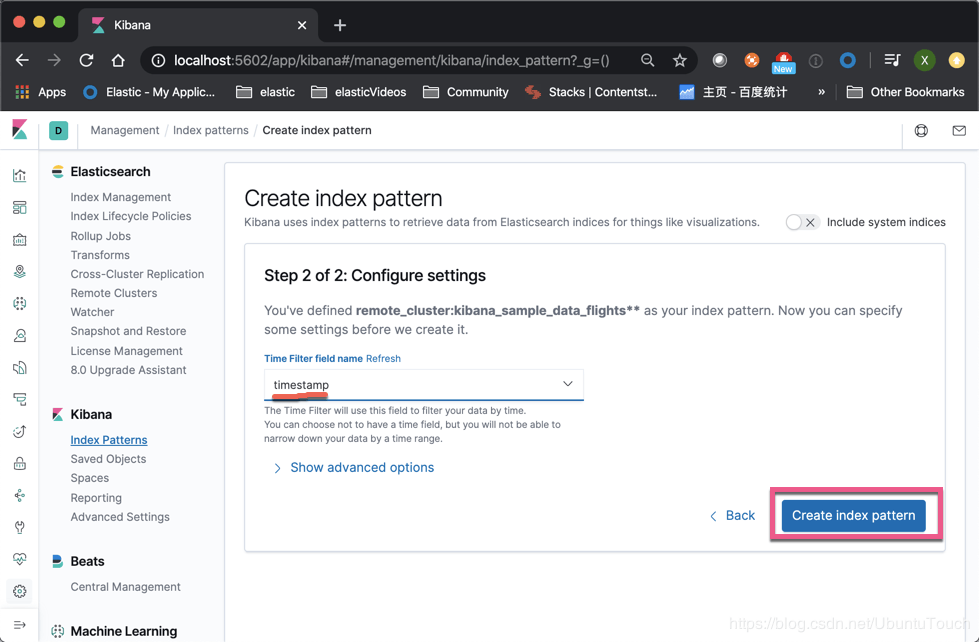

我们打开 Kibana_2,并创建一个为 cluster_1 中的 Sample flight data 的 index pattern。

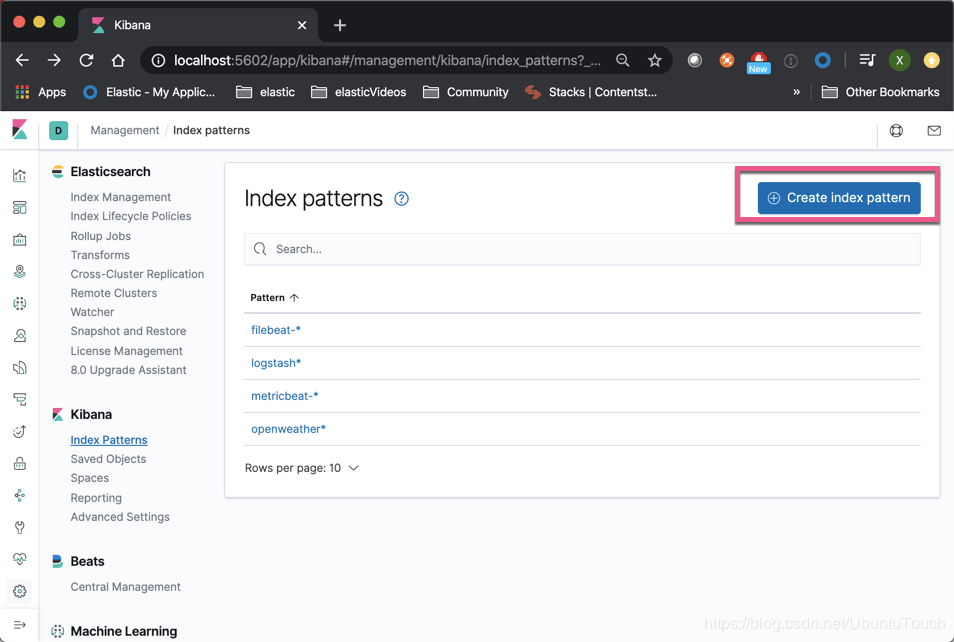

点击“Create index pattern”:

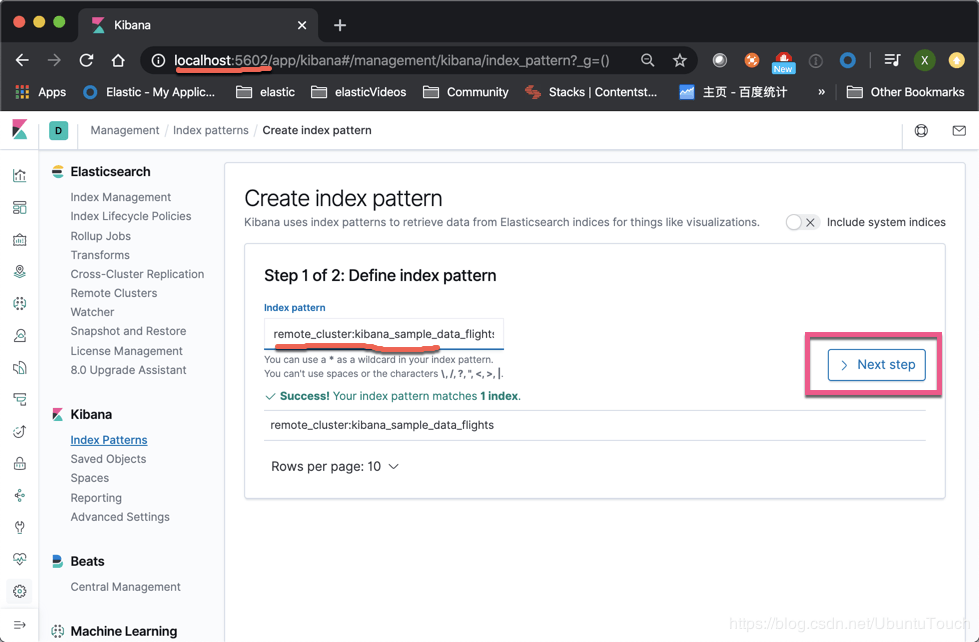

输入我们想要的索引,注意在前面加上 remote_cluster:

在上面,如果我们有本地和远程相同类型的索引(比如,我们针对不同地区的服务器来收集数据),我们可以使用逗号“,”把所有的索引放在一起做成一个 index pattern,比如就像:remote_cluster: kibana_sample_data_flights, my_local_index。

点击“Create index pattern”:

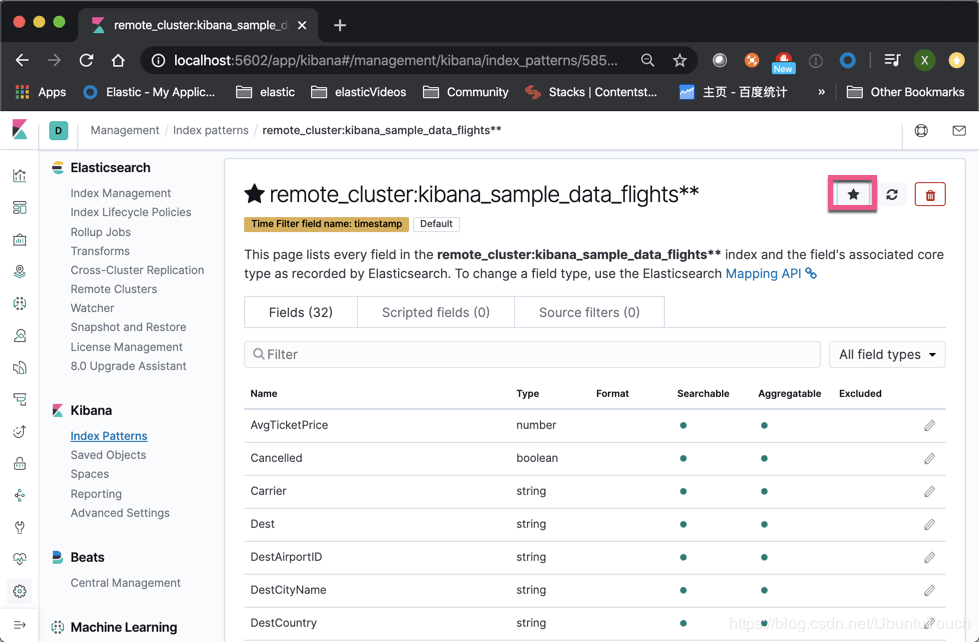

这样,我们就创建了位于 cluster_1 里的索引的一个 index pattern。我们点击右上角的星号,并使之成为我们的默认的 index。我们点击 Kibana_2 左上角的 Discover:

因为我们的默认的 index 是 remote_cluster: kibana_sample_data_flights,所以我们的 Discover 默认的情况先显示的是所有关于位于 cluster_1 上的 kibana_sample_data_flights 索引数据。我们可以在 cluster_2 对这些数据进行分析。

作者:刘晓国

来源:Elastic中文社区

原文链接:mp.weixin.qq.com/s/1GsfON2sFLh07dH...

关于 LearnKu

关于 LearnKu