网站采集接口,每分钟差不多有100个左右得接口要采集

网站是个数据采集api系统

数据都是从别人的网站采集过来的,大概有100个三方api接口

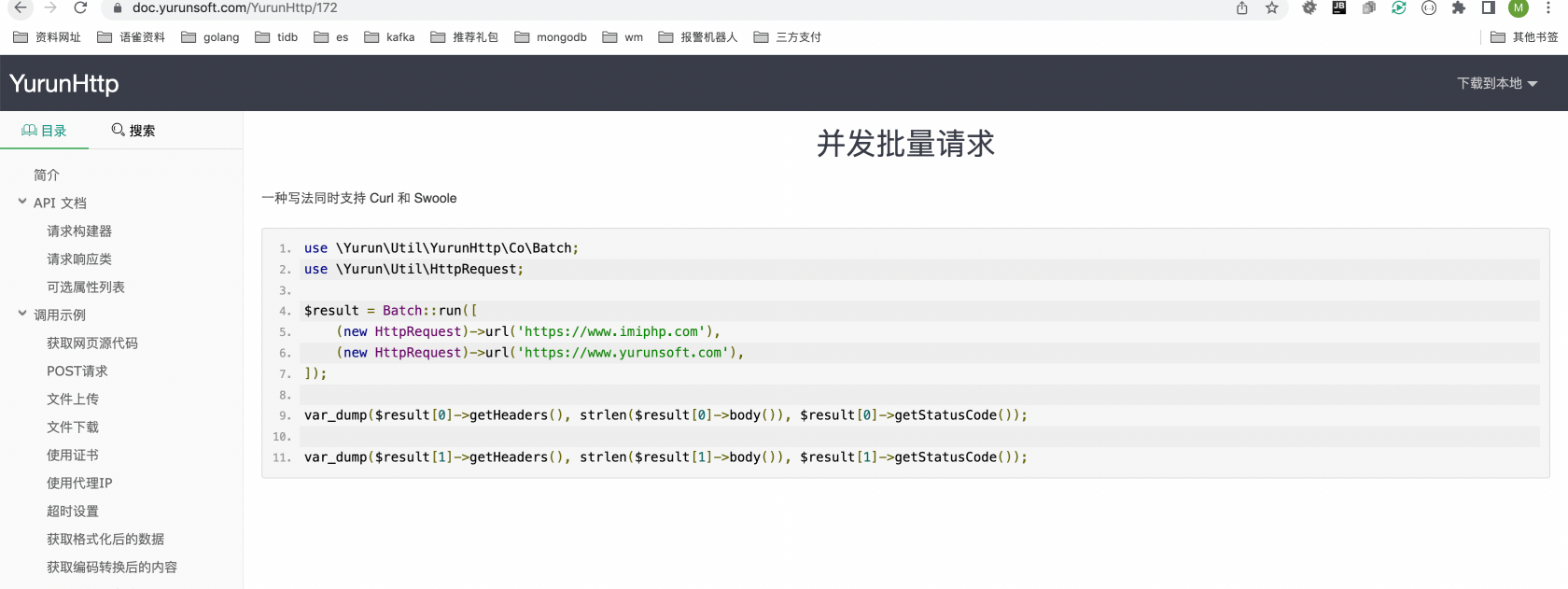

为了保证数据快速获取,每分钟都要请求一次三方api接口,每次都要请求100个左右CURL

每次采集第三方接口的时候服务器CPU基本都是100%,搞得我头大,同时还有别人采集我的数据

采集三方api逻辑大概就是采集到数据然后 in判断数据库是否存在,如果不存在就批量入库,如果存在就更新指定字段

开始的时候没考虑那么多三方api,现在想分表,但是业务逻辑不太允许,现在不知道怎么优化了,有合适的方案么,数据量大概有500W+,超过500W我就会手动清理下

用的宝塔NGINX + mysql5.6 + php7.3 所有配置都是默认的,没改过东西

都是自学的,实在是不知道怎么优化了

关于 LearnKu

关于 LearnKu

推荐文章: