U-Net Transformer: Self and Cross Attention for Medical Image Segmentation

引言

U-Transformer网络利用transformers的强大能力来模拟解剖结构之间的长期相互作用和空间关系。通过使用U形架构保持卷积的感应偏置,在两个主要层次引入了注意力机制,这有助于解释模型决策。

首先,自我关注模块利用编码器末端语义特征之间的全局交互来显式地建模完整的上下文信息。

其次,在跳跃连接中引入交叉注意,以过滤掉非语义特征,允许在U-Net解码器中进行精细的空间恢复。

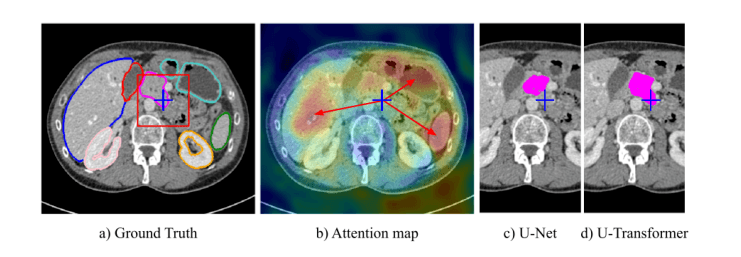

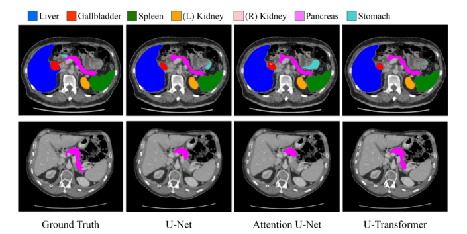

全局环境对于复杂的器官分割是至关重要的,但是不能被普通U-Net所捕获。例如a中的蓝十字区域。

图b为U-Transformer网络通过注意力来表示完整的图像上下文。

The U-Transformer Network

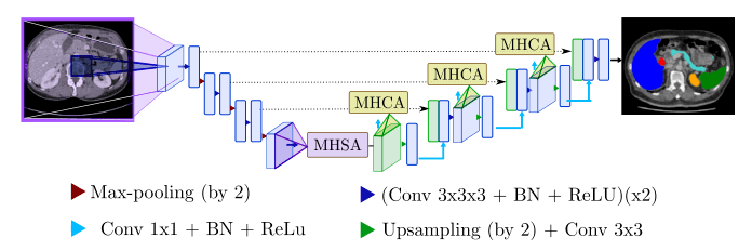

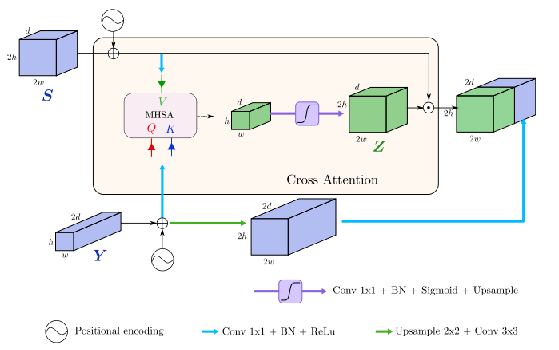

U-Transformer通过使用两种类型的注意力模块来模拟长期的上下文交互和空间依赖性。包括:多头自我关注(MHSA)和多头交叉关注(MHCA)

U-Transformer用Transformer扩展了U-net。U-Net编码器末端的多头自我注意(MHSA)模块提供了包含整个图像的感受野(紫色),蓝色为有限的U-Net感受野。

MHSA模块

MHSA模块旨在从图像中提取远程结构信息。它由U形网底部的多头自我注意功能组成。

MHSA的主要目标是将最高特征地图中的每个元素相互连接起来,从而获得所有输入图像的感受野。

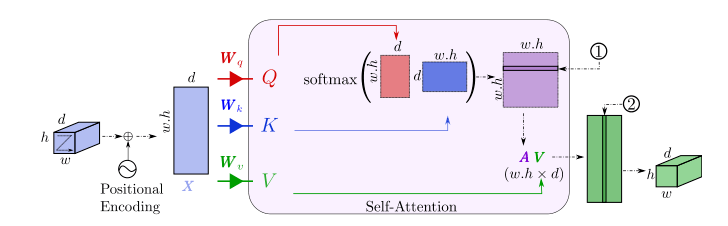

自我关注模块接受三个输入:

注意矩阵A是Q中给定元素相对于K中所有元素的相似性。

Q、K和V具有相同的大小,并且对应于由X表示的最高级别特征映射的不同学习嵌入。嵌入矩阵表示为Wq、Wk和Wv

此外,为了考虑绝对上下文信息,向输入特征添加位置编码。它特别适用于医学图像分割,其中不同的解剖结构遵循固定的空间位置。

MHCA模块

MHCA模块背后的理念是关闭跳过连接功能中不相关或有噪声的区域,并突出显示对应用有重要意义的区域.MHCA块被设计为跳过连接S的选通操作。

通过sigmoid激活函数在0和1之间重新调整计算的权重值,得到结果张量Z(滤波器),再哈达玛积一个S干净的版本。

哈达玛积是矩阵的一类运算,若A=(aij)和B=(bij)是两个同阶矩阵,若cij=aij×bij,则称矩阵C=(cij)为A和B的哈达玛积,或称基本积

最后,该滤波操作的结果与高级特征张量Y连接。

Experiments

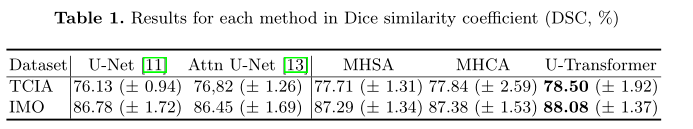

TCIA胰腺公共数据集和内部多器官数据集上评估了用于腹部器官分割的U-Transformer包含82个带像素级注释的CT扫描。每次CT扫描有大约181个512 × 512像素的466切片。

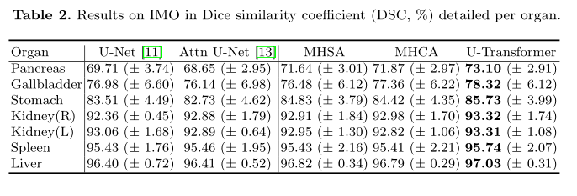

我们还用内部多器官(IMO)数据集进行了实验,该数据集由85个带7个类别注释的CT扫描组成:肝脏、胆囊、胰腺、脾脏、左右肾和胃。每次CT扫描约有57到500个512 × 512像素的切片。

为了公平比较,我们将U-Transformer与U-Net基线和Attention U-Net进行了比较。

MHSA和MHCA在UTransformer中的结合表明,这两种注意机制是互补的,可以合作提供更好的分割预测。

U-Transformer在困难的情况下表现更好,在这些情况下,局部结构是模糊的。

每个器官的详细结果:

每天一篇CV paper

每天一篇CV paper

关于 LearnKu

关于 LearnKu