Python 爬虫入门问题

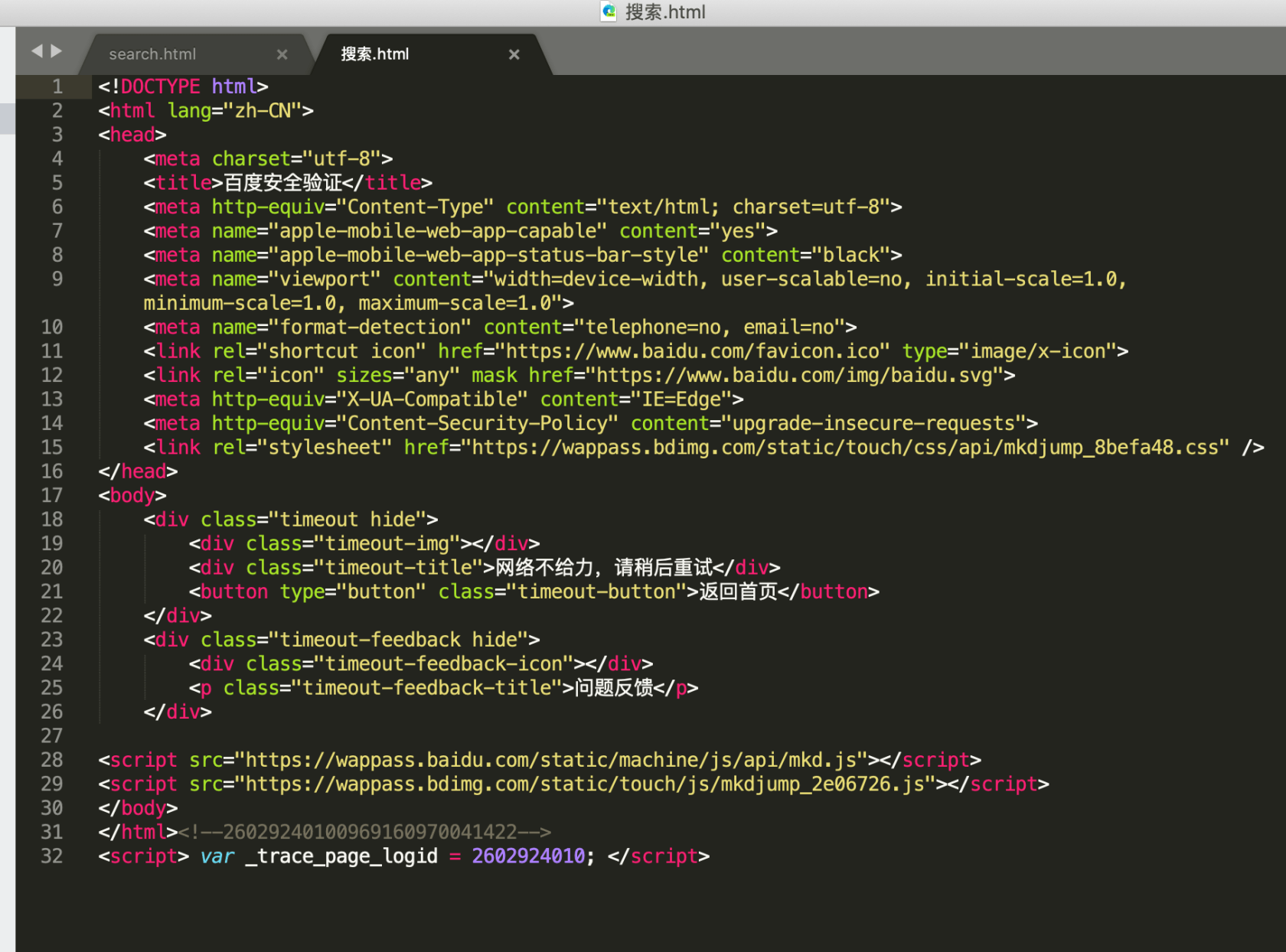

我这个代码运行后,输入任意中文,然后用编译器打搜索.html,为啥会呈现图片中的文字:网络不给力,请稍后重试,不理解。希望得到解答,谢谢。

import urllib.request

import urllib.parse

# 拼接URL

basedurl = "http://baidu.com/s?"

key = input("请输入要搜索的内容:")

# 进行urlencode()编码

wd = {"wd": key}

key = urllib.parse.urlencode(wd)

url = basedurl + key

headers = {"User-Agent": "Mozilla/5.0"}

# 创建请求对象

req = urllib.request.Request(url, headers=headers)

# 获取响应对象

res = urllib.request.urlopen(req)

html = res.read().decode("utf-8")

# 写入本地文件

with open("搜索.html", "w", encoding="utf-8") as f:

f.write(html)

关于 LearnKu

关于 LearnKu

爬取搜索引擎?很明显,百度搜索查出来了你是机器人。我之前弄过百度搜索和百度翻译,基本上百度的网站都是cookie验证而不是user-agent认证的。所以说,user-agent其实不用加的,但是cookie必须要加。否则,百度会判断你是机器人并给你个安全验证。

参考代码:

怕你不会找cookie,这个cookie就给你了。反正这是一个游客cookie