meilisearch导入840654条数据时,巨卡

你们在使用meilisearch的时候,当导入大量的数据的时候会不会很卡。

linux环境下,4核,8G内存

使用队列导入

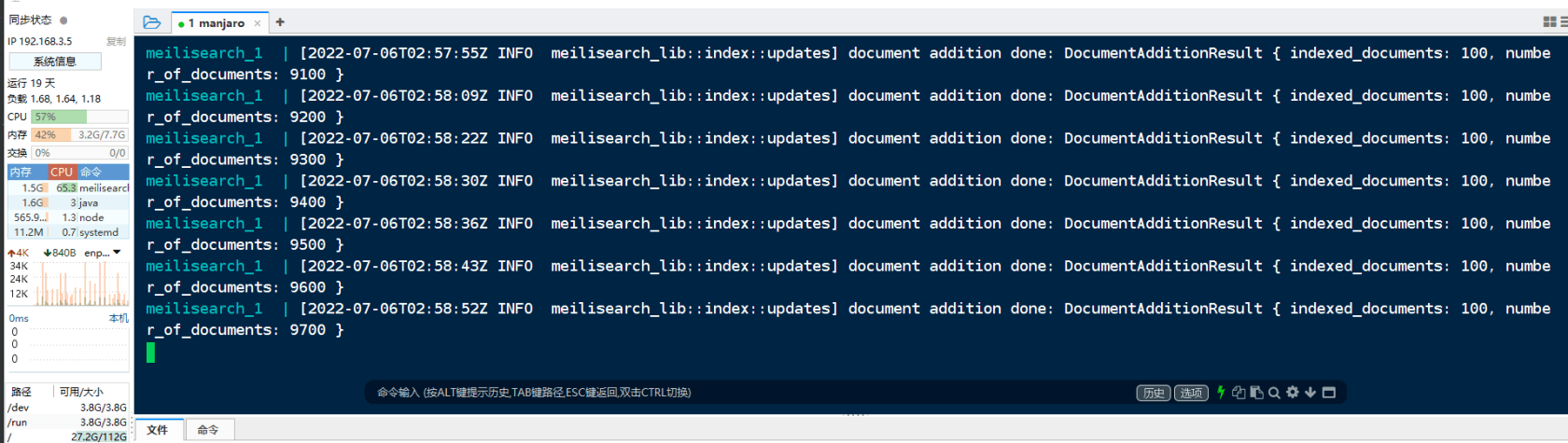

meilisearch docker日志

感觉超级缓慢,如果启用多个 php artisan queue:work 服务器直接就卡死了。

你们遇到这个问题是如何处理的?

关于 LearnKu

关于 LearnKu

导入数据,使用事务肯定卡死

建议(当然,不一定全)

队列中执行完任务 1 ,才会执行任务 2,(貌似是可以后台执行,就是启动另一个进程执行,不确定)

MySQL不在一个内网或同一台主机暂时这些把。 继续上班

会,当时百万数据花了大半天,用起来也不太符合场景,然后抛弃了 :smile:

想知道80多w数据占多少内存,之前试过导入十多万数据,占差不多3G内存,是xunsearch的3倍,果断放弃了