将表里面的 1000w 条数据导出到 txt,怎样导出速度更快?

送礼表send_gifts,按月分表,例如:send_gift_2019_5。

现要将40个月近1000w条数据导出到txt。

各位大佬有什么好的解决方案吗?

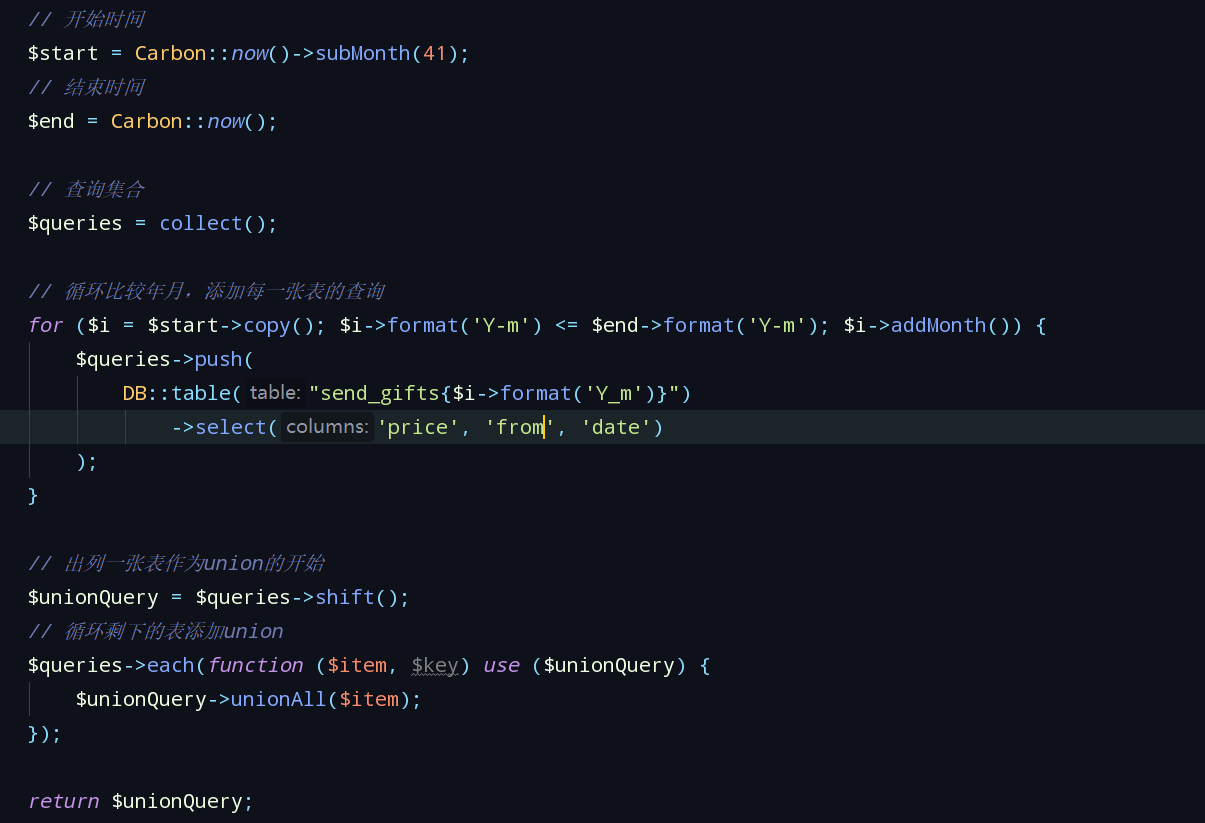

下面是分表查询的数据

关于 LearnKu

关于 LearnKu

能问下为啥要导出到 txt 里面么,如果导出文件过大的话很多可能有现有的工具都打不开,还得额外借助 BigQuery 之类的工具。另外建议说下具体上面的写法碰到的问题,这样可以获得更有针对性的解答。

命令行使用chunk获取,然后放入txt

@yuesir

这个是导出方法,出现的问题就是 导出的速度比较慢,最后还没导出成功

@mysql 使用的是chunk,但是导出的速度太慢,最后还导出不成功

除了

chunk,可以考虑下用PHP stream和迭代器chunk在数据量很大的情况下效率是很低的。建议使用chunkById方法通过主键切分数据来查询。另外,写这么多数据到同一个文件可能还打开不了......我觉得最好分几个文件。这种场景下,不建议使用file_get_content,好像file_get_content 每次使用都要打开文件资源。

可以采取一般的写文件

fopen配合fwrite

可以试下yield生成器

这样1000W数据大概用了50s写入文件